Ik herinner me mijn eerste ervaring met SONOS nog heel goed. We spreken halverwege herfst 2009. Ik werd uitgenodigd op een launch event, als ik me goed herinner in de Belga Queen in Brussel, waar we een korte uitleg kregen en vooral een eerste ervaring hadden met de S5 (nu de PLAY:5).

In die tijd was er nog geen sprake van de kleinere broertjes, laat staan van een app voor menig smartphone. Toen was er zelfs nog de SONOS remote control (bestaat dat ding vandaag nog? Is daar nog een markt voor nu iedereen minstens 1 smartphone en/of tablet in huis heeft?) – denk iPod Touch maar dan van SONOS.

Niet veel later kreeg ik twee S5’s om me een tijdje mee te amuseren. Het enige nadeel aan die toestellen indertijd? Het feit dat ik ze moest teruggeven aan SONOS.

De prijs was ook niet mals en zat in lijn met wat de PLAY:5 vandaag moet kosten. Dat was dan ook ineens de reden waarom ik er geen kocht… dat en het feit dat ik toen volop met mijn bouwproject bezig was.

Today

Flash forward naar het heden: SONOS is nog altijd king of the world wanneer het aankomt op draadloze speakers die kwalitatief sterk staan terwijl ze een hoog gebruiksgemak met zich meebrengen.

Ik kocht een PLAY:1 voor de woonkamer omdat die niet alleen een aantrekkelijke prijs heeft, maar ik kreeg er ineens ook een SONOS Bridge gratis bij. Die laatste zorgt ervoor dat de speakers zelf enkel een stroomaansluiting nodig hebben. De Bridge kan je zien als een wifi access point voor SONOS speakers langs waar ze toegang krijgen tot je lokale muziek op je laptop, op je NAS, op je mediaserver, in je Spotify account, op je Soundcloud profiel,… en ga zo maar door. De lijst is eindeloos en SONOS maakt er een punt van om constant nieuwe platformen toe te voegen.

Die PLAY:1, daar ben ik super tevreden over. Klein maar extreem dapper is de beste manier om hem te omschrijven. De klanken en de decibels die dat ding produceren kennen hun gelijke niet, zonder dat de kwaliteit het moet bekopen weliswaar. Het enige waar er marge is om te groeien, is de bass productie. Logisch als je ziet hoe klein de speaker is. Works as designed zeg maar.

Omdat ik graag meer bass wou in de woonruimte, was ik op zoek naar een broertje of twee. Mijn oorspronkelijk idee was om nog een PLAY:1 aan te schaffen om aan de andere kant van de kamer te plaatsen + een PLAY:5 die de diepere tonen uitbraakt. SONOS heeft echter ook nog een tussenmodel – de PLAY:3 – en dus wat ik met een dilemma. Wat moest ik nu kopen?

Uitbereiding?

Een tweet richting de mensen van SONOS en hun partners in crime zorgden voor de oplossing: ik kreeg een PLAY:3 en een PLAY:5 toegestuurd zodat ik beide speakers aan mijn setup kon toevoegen en evalueren welke het meest geschikt was.

Fantastisch toch? Zo verkoop je je producten – seeing is believing – geloven dat je producten de klant overtuigen zonder veel gezever!

Boy were they right!

Na bijna drie maanden muzikale orgasmes door de woonkamer te jagen, kan ik maar een ding concluderen: ik wil ze niet meer kwijt. Spijtig genoeg was dat niet de afspraak en dus gaan de speakers onherroepelijk terug naar de SONOS laboratoria, maar ondergetekende is overtuigd dat er meer SONOS’ nodig zijn in casa Unexpected.

Die PLAY:3 vind ik niet verschillend genoeg van de PLAY:1 om de meerprijs van €100 te verantwoorden. Hij heeft meer speakers, maar ik hoor het verschil nauwelijks. Iets dieper geluid misschien, maar alleen merkbaar als ik mijn PLAY:1 en PLAY:3 afwissel om de verschillen te zoeken.

De PLAY:5 daarentegen is de party booster van de familie. Het verschil tussen de kleinste en de grootste telg van de familie is zonder twijfel merkbaar. Nog luider, nog vollere klank en vooral ook veel betere weergave van de lage tonen.

Mijn woonkamer setup zal dus 2 x PLAY:1 en 1 x PLAY:5 worden – mijn oorspronkelijke keuze dus. Daarnaast komt er nog een PLAY:1 in de badkamer en eentje in het bureau. Allemaal maagdelijk wit aub, want die zwarte test-exemplaren vangen iets teveel stof naar mijn zin…

Conclusie

Ik ben al jaren fan, kocht er zelf eentje begin 2014 en na deze testperiode komen er nog enkele bij. SONOS wint voor mij op vlak van design, maar veel belangrijker ook op vlak van ondersteuning en de drang van het bedrijf om zichzelf constant te willen verbeteren.

Opstaan met digitale radio (dus in perfecte kwaliteit, zoals DAB dus), Tomorrowland streamen, Spotify playlists door de kamer knallen of mijn laatste Soundcloud “likes” luisteren… het zijn maar enkele van de use-cases waaraan ik mijn setup dagelijks onderwerp, met succes en zonder veel gedoe. It just works.

Als dat geen goed argument is om u te overtuigen dit merk te beschouwen als u op zoek bent naar een nieuwe geluidsinstallatie die net dat ietsje meer kan, dan weet ik het ook niet meer.

Vrienden en kennissen die me vragen wat te kopen, heb ik richting SONOS gestuurd. Vandaag zijn zij ook SONOS-adepten pur sang – betere evangelisten kan een merk zich niet wensen denk ik dan.

The proof is in the SONOS pudding. Of zo iets.

Category: Netwerk (Page 1 of 3)

IDC heeft een nieuwe term bedacht voor de “hyper converged systems” waarvan Nutanix u waarschijnlijk het meest bekend in de oren klinkt: Compustorage Clusters.

Aangezien die systemen zo goed als altijd uit nodes bestaan, zijn het per definitie clusters en omdat je ze niet granulair kan “scalen” (lees: als je alleen storage wil of alleen compute power, dan heb je pech want je upgrade in nodes en die bevatten altijd beide componenten), noemen ze het “Compustorage Clusters”.

Me like.

Telenet heeft een subsite online geplaatst waarin ze uitleggen waar ze staan met hun (lees: dat van Mobistar) mobiel netwerk, wat ze de komende maanden en jaren van plan zijn en hoe ze vandaag scoren ten opzichte van Base en Proximus.

Men zegt dat die kwaliteits- en snelheidstesten uitgevoerd worden door een onafhankelijk bureau. Dat geloof ik allemaal wel, maar desondanks trek ik die resultaten toch zwaar in twijfel, puur en alleen gebaseerd op wat ik als klant van alle drie de providers heb ondervonden.

Men zegt daar bijvoorbeeld dat het 3G bereik van Proximus op 99,6% zit, dat van Base op 98,5% landt en dat van Mobistar/Telenet op 98,3% aftekent.

Ter illustratie: ik heb twee gsm’s die ik altijd bij me heb. Eentje privé (iPhone5) en eentje professioneel (BlackBerry Bold). Die laatste zit op het Proximus netwerk terwijl de iPhone eerst op Base (Mobile Vikings) zat, daarna net geen jaar op Telenet (en dus Mobistar) aangesloten was en sinds twee weken ook op het Proximus netwerk zit.

Beroepsmatig bevind ik mij doorheen gans België, maar leg ik de verbinding Deinze-Leuven op dagelijkse basis af. Ik doorkruis gemiddeld drie provincies per dag en bevind mij her en der op onze wegen, met andere woorden: ik kan écht wel vergelijken hoe het met de ontvangst (dus ook telefonie) en de 3G dekking gesteld is.

Als we die cijfers dus mogen geloven, dan zou Mobistar/Telenet “slechts” 1,3% minder 3G dekking bieden dan Proximus. Base zou zelfs “maar” 1,1% minder 3G dekking bieden.

Wel, ik durf te stellen dat deze cijfers compleet van de pot gerukt zijn. Ik nodig die mensen dan ook uit om eens een dagje met mij mee te rijden en te vergelijken. Voor alle duidelijkheid: ik word niet betaald door een of andere provider, ik betaal mijn facturen zelf en ik heb er geen baat bij om de ene provider te promoten ten koste van een andere.

Proximus heeft zonder enige twijfel de beste 3G dekking, en dat scheelt echt wel meer dan die luttele procentpunten die ze ons meegeven. Bij Base heb je echt wel meer Edge dan 3G connectie, maar dat is niet zo heel erg, want zij hebben ook niet de pretentie om dat te claimen. Ik spreek nu eigenlijk over Mobile Vikings, die zich profileren als beste prijs / kwaliteit provider en daar goed in slagen. Ik ben altijd een tevreden gebruiker geweest, maar het ontbreken van 3G heeft me uiteindelijk toch doen veranderen.

Mobistar gaf mij meer 3G ontvangst ten opzichte van Base. Of beter gezegd, het 3G logo kwam meer op mijn toestel tevoorschijn, want heel vaak stond er 3G, maar werkte het gewoon niet. Ook niet traag. Het toestel verplichten op Edge te connecteren was dan de enige manier om toch “mobiel internet” te kunnen gebruiken. En daar komt nog de kanttekening bij dat naar mijn subjectief gevoel de Edge connecties van Base sneller werken dan die van Mobistar/Telenet.

Tijdens mijn periode bij Mobistar/Telenet waren er ook verschillende plaatsen waar ik gewoon geen ontvangst had. Dat af en toe het mobiel internet niet werkte was ik al gewoon, maar soms stond er gewoon “No Service” op het scherm. Een “deadzone” in hun netwerk dus. Als je op dat moment aan het bellen was, dan viel de verbinding uiteraard gewoon weg en moest je wachten tot je terug in de buurt van een zendmast kwam. Een voorbeeld van zo een plaats: de E40 Brussel-Gent vanaf Groot-Bijgaarden tot iets voor Aalst. Test het maar uit en kijk toe hoe je mobiel internet wegvalt en als je pech hebt, ook je volledige verbinding als sneeuw voor de zon smelt.

Mijn thuis-werk-traject bestond vroeger uit “meestal Edge, heel soms 3G en af en toe volledig niks” verbindingen. Na twee weken met Proximus moet ik op datzelfde traject mijn best toen om een verbinding te vinden die géén 3G bevat…

Neen, ik rijd niet met speciale apparatuur in de wagen rond, noch staan er gigantische antennes op mijn dak. Ja, ik gebruik een iPhone5 van Apple en ja ik weet dat die niet uitblinken in ontvangst. Maar guess what: veel mensen hebben nu eenmaal zo een toestel, hebben daar veel geld voor uitgegeven en verwachten dan ook dat dat gewoon werkt. Perceptie is nu eenmaal realiteit, of die nu objectief of subjectief is.

Mobistar/Telenet goochelt met beloftes van 4G tegen het einde van 2013. Wake-up call: Proximus biedt het vandaag al aan! En eerlijk gezegd, er zijn weinig toestellen die vandaag 4G kunnen gebruiken en ik denk dat er ook weinig gebruikers zijn die zulke mobiele snelheden vandaag al nodig hebben.

Edge daarentegen is vandaag de dag echt te traag geworden voor vele toepassingen. Mensen hebben vandaag een nood aan een goede 3G connectie, dus in plaats van altijd opnieuw een gloednieuwe technologie te “showen” die mooi werkt tijdens een “Proof of Concept”, zou ik voorstellen om te zorgen dat wat er vandaag “in the field” bestaat, deftig werkt. Daar zouden mensen gelukkig van worden en je product aanbevelen bij derden.

3G verbindingen die gewoon niet werken, trage Edge connecties en zelfs het volledig wegvallen van je netwerk zijn écht geen kwaaltjes van deze tijd meer. Een tijd waarin iedereen en alles in een permanente “online” vorm bestaat, waar alles meer en meer in de “Cloud” zit, smeekt om een constante, kwalitatieve verbinding met de buitenwereld.

Mijn advies halverwege 2013: zoek je de beste prijs/kwaliteit provider, ga dan voor Mobile Vikings. Wil je gewoon de beste kwaliteit tegen een iets hogere kost, dan is Proximus uw beste keuze. Voor een derde speler die op geen van beide vlakken voeten aan wal heeft, is er geen plaats.

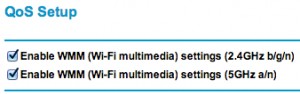

Geen Griekse les vandaag. Atheros is de naam van de chipset die in veel wireless routers te vinden is. Zo ook in de Netgear 3700 reeks die ik al enkele jaren in gebruik heb.

Zeer tevreden van, maar de draadloze netwerksnelheid viel de laatste tijd wat tegen. Kort gezegd: ik kwam niet verder dan 54Mbps wat overeenkomt met de 802.11G standaard terwijl de router van het 802.11N type is en dus net geen zes keer sneller kan werken (300Mbps).

Ik mix geen oudere B/G-clients in mijn N-netwerk en alle drivers zijn up to date. Ik vond dus niet direct een oorzaak voor mijn probleem en ik was niet geneigd om er veel tijd aan te spenderen omdat ik wireless vooral gebruik voor surfen en daarvoor is 54Mbps eigenlijk voldoende…

Vandaag was ik echter wat aan het prutsen met wat settings op de router en opeens zie ik mijn downloadsnelheid van 2MB/s naar 9MB/s springen! Buiten het aanvinken van WMM (Wi-Fi Multimedia) – een setting in het QOS (Quality Of Service) gedeelte van de settings op de router – heb ik niets gewijzigd en nader onderzoek blijkt helderheid te scheppen!

Als je meer dan 54Mbps wil halen met een “Atheros” gebaseerde router, dan moet je die WMM setting dus op “Enable” laten staan.

Als je dus over zo een router beschikt, zou ik ten zeerste aanraden om deze setting te controleren.

PS: wees er bewust van dat die Mbps snelheden die men opgeeft bij routers, netwerkkaarten enz (en dan vooral bij draadloze varianten) een theoretische aangelegenheid zijn. Verwacht dus niet dat je met een 802.11N router aan 300Mbps draadloos kan surfen.

Ik heb voor mijn privé abonnement gekozen voor Telenet Mobile. Telenet maakt hiervoor gebruik van het Mobistar netwerk voor zij die dat niet weten.

Voordien was ik klant bij Mobile Vikings, wat gebruik maakt van het BASE netwerk. Mobistar zou meer 3G dekking hebben dan BASE en daarom heb ik besloten om de overstap te maken.

Huge mistake!

Telenet Mobile / Mobistar heeft inderdaad meer 3G dekking en als die er is, dan is alles best ok te noemen. Echter, wanneer er geen 3G is, dan val je terug op Edge en die kwaliteit is echt bedroevend slecht!

Of je nu 2 balkjes of 5 balkjes hebt, het maakt allemaal niet veel verschil. Je toestel denkt dat het op internet kan, maar in de praktijk werkt het meer niet dan wel en krijg je time-out fouten enz. Zelfs een simpele “PING-test” lukt niet… dus het heeft niets te maken met grote hoeveelheden data proberen te transferen.

Ik heb contact opgenomen met Telenet en die support was zeer vriendelijk (zowel via Twitter als via telefoon, ze hebben me zelf opgebeld om toelichting te geven), maar ze hebben te kennen gegeven dat ze er zelf weinig kunnen aan veranderen omdat ze van Mobistar afhankelijk zijn en dat ze zich zeker bewust zijn van die slechte kwaliteit voor niet-3G-connecties.

Mobile Vikings / BASE heeft dan misschien minder 3G dekking, maar hun Edge verbindingen werken wel goed en de snelheid valt nog goed mee ook.

Concreet: er zit niks anders op dat van provider veranderen… Ik denk dat ik Proximus Generation Connect eens een kans ga geven.

Omdat ik hier toch vaak over storage en aanverwanten leuter en soms te horen krijg dat het allemaal nogal “Chinees” is, lijkt het me opportuun om de basisconcepten ervan toe te lichten zodat geïnteresseerden mee kunnen met mijn meer technische blogposts.

Het is niet de bedoeling om een technisch naslagwerk te schrijven, want daar staat het internet al vol van en die bestaande “whitepapers” leggen dat ook beter en meer gedetailleerd uit dan dat ik dat hier zou kunnen / willen.

Neen, het idee is dat ik op deze manier minder technische lezers een blik achter de schermen geef in “mijn wereld”, het inzicht geef dat ze zonder het te weten waarschijnlijk elke dag met zulke systemen in aanraking komen én misschien wel warm maak om er meer over te weten te komen.

Anyway – here goes!

Storage kennen de meeste mensen in de vorm van een harde schijf (als je echt extreem “not into IT” bent, kan je nog aan kasten van IKEA enz denken, maar dat is het dus niet!).

Een harde schijf vinden we terug in elke computer (gemakkelijkheidshalve beschouw ik een SSD oftewel Solid State Drive ook als harde schijf in dit verhaal), al dan niet intern of extern (USB, FireWire, eSATA) en wordt gebruikt om je data te bewaren.

Voor een PC is dat uiteraard prima, maar wat als je nu met verschillende servers (=grotere, snellere computers die applicaties draaien zoals de e-mail software, de databases,…) opgezadeld bent – lees: elke bedrijf dat meer dan 25 werknemers heeft (ok, die 25 is een beetje nattevingerwerk, maar je weet wat ik bedoel).

Op dat niveau werkt men uiteraard niet met externe harde schijven en wil men eigenlijk ook niet werken met interne harde schijven (in de servers welteverstaan) omdat dat de beheerbaarheid, het backup-verhaal, maar zeker en vast ook de performantie (zeer belangrijk) niet ten goede komt.

Om die eerder genoemde tekortkomingen te omzeilen, gebruiken de meeste bedrijven een “shared storage” oplossing. De naam zegt het zelf: een storage oplossing die gedeeld wordt met anderen en met anderen bedoel ik “servers”.

Concreet kan je een shared storage systeem dus beschouwen als een verzameling van harde schijven die via een netwerk toegankelijk zijn voor elke computer / server. Iedere computer bewaart zijn data op die centrale storage, waardoor het beheer van alle data veel makkelijker is. Say hello to my world!

Het performantie verhaal is te verklaren als volgt:

- Centrale storage oplossingen bevatten controllers (servers die niks anders doen dan data beheren zeg maar) die gebouwd zijn om data zo snel mogelijk te kunnen verwerken. Een “normale” computer heeft veel meer taken dan je data beheren (surfen op internet, muziek afspelen, foto’s bewerken, gamen,…) en is dus eerder in veel goed, maar blinkt in niets uit. Op je computer thuis merk je daar natuurlijk niets van, maar beeld je eens in dat er 100 mensen tegelijkertijd bestanden van en naar je computer zouden kopiëren… En net dat is wat er in bedrijven constant gebeurt (mails die binnenkomen en verstuurd worden, mensen die in databanken updates doen, printers die bladzijden uitspuwen… en ga zo maar door).

- Centrale storage bevat ook veel meer harde schijven – vanaf nu noemen we dat “spindles”, afkomstig van het werkwoord “spinning” oftewel draaien – en de logica leert ons dat de snelheid waarmee je data gelezen en geschreven kan worden, evenredig is met het aantal spindles waarop de data verspreid wordt. Uiteraard zijn er nog andere factoren die de snelheid beïnvloeden, maar daar kom ik in een latere vervolgblogpost op terug zodat het niet te ingewikkeld wordt.

Shared storage bestaat in verschillende varianten, maar grosso modo kunnen we stellen dat er twee soorten zijn: SAN en NAS. Dezelfde drie letters, maar in omgekeerde volgorde en die volgorde maakt wel degelijk een wereld van verschil.

SAN staat voor “Storage Area Network” terwijl NAS de afkorting is van “Network Attached Storage”. Klinkt gelijkend, maar is het dus helemaal niet.

Waar de verschillen juist liggen, daar kom ik de komende dagen op terug. Het belangrijkste is dat je nu het concept van “shared storage” of centrale opslag zou moeten begrijpen, maar ook beseffen waarom het interessanter is dan decentrale opslag van data.

Feedback, vragen of andere uiteraard welkom in de commentaar!

Sinds vorige week heb ik een account op App.net – een betalende tegenhanger van Twitter waardoor de makers kunnen garanderen dat er geen commerciele initiatieven zullen plaatsvinden zoals betaalde tweets, gesponsorde accounts,… Los daarvan ziet het er allemaal uit zoals Twitter, met als grootste verschil dat je 256 karakters kan schrijven in een bericht ipv 140 bij Twitter. Check zeker de website om een meer “in depth” uitleg te krijgen van het hoe en waarom…

Uiteraard zit er nog niet zoveel volk op App.net (de kostprijs is $36 per jaar, Twitter is gratis…) maar ik heb de indruk dat de berichten “interessanter” zijn. Al wie al een tijdje op Twitter zit, heeft dat platform zonder twijfel zien transformeren van een push-berichten-platform naar een alternatief op mIRC, MSN en consoorten. Veel “nieuwe” twitterati voeren ganse chatgesprekken op Twitter, wat volgens mij in gaat tegen de oorspronkelijke bedoeling van het concept.

Nu goed. De gebruikers bepalen waar het platform naartoe gaat en daarmee basta. Mij stoort het af en toe en daarom dwaal ik nu ook rond in App.net. U kan me daar vinden onder dezelfde handle als op twitter – namelijk “Unexxx”.

Op de iPhone gebruik ik trouwens NetBot als client, een app van de makers van TweetBot. Zelfde interface, zelfde manier van werken, andere kleurtjes. Handig.

Tot straks, op App.net?

Indrukwekkend hoe ze bij Google met je data omgaan. De moeite om eens te bekijken dus.

httpv://www.youtube.com/watch?v=1SCZzgfdTBo

Hoe meer data je hebt, hoe meer de noodzaak voor een goed systeem om alles een plaats te geven. Backups, documenten, foto’s, bookmarks, text-files, slidedecks,… you name it. De tijd van megabytes is al lang vervlogen. Zelfs gigabytes beginnen geschiedenis te worden. Vandaag, zelfs in “consumer” omgevingen – lees: in je eigen huis – zijn terabytes al schering en inslag.

Ik heb twee laptops: mijn persoonlijke Macbook en een ThinkPad van de werkgever. Daar begint het probleem al. Ik wil graag al mijn werkgerelateerde documenten beschikbaar hebben op mijn Macbook, maar ook op mijn iPhone of iPad bijvoorbeeld. Als ik ‘s avonds aan iets denk of ik wil nog snel een document of presentatie overlopen, dan heb ik geen zin om mijn ThinkPad te gaan zoeken, op te starten en te wachten. Dan wil ik gewoon mijn iPad van de salontafel pakken en dat document openen.

Vroeger werd zo iets opgelost met zaken doormailen. Of op een USB-stick zetten. Maar dan zit je met verschillende versies van een bestand, met alle gevolgen vandien. Corrupte files (ik denk aan “Available Offline” van Windows – de slechtste uitvinding ooit), niet meer weten welke versie de juiste is, de verkeerde versie meehebben,…

Om dat euvel op te lossen, gebruik ik “de Cloud”. In mijn geval is die cloud DropBox (en in beperkte mate iCloud en Google). Dat cloud-gebeuren lost mijn probleem van verschillende versies her en der op. Ik moet ook slechts één “file repository” backuppen. Win-win dus.

Maar DropBox is niet alles uiteraard. Mijn werklaptop wordt niet verder gebackupped. Alles wat van belang is, zit in mijn eigen “private cloud”, de rest – lees: OS en applicaties – kan mij gestolen worden. Als mijn ThinkPad sterft, kapot gaat, gestolen wordt,… is het gewoon een kwestie van een nieuwe ThinkPad te bestellen en mijn cloud applicatie erop te installeren.

Mijn Macbook zit naast dat cloud-gebeuren, wel nog verwikkeld in een backup structuur. Mijn Macbook bevat ook mijn muziek, mijn foto’s, mijn hebben en mijn houden zeg maar. Documenten zitten in de cloud, maar de “media” niet. Of toch niet in DropBox en consoorten, want daarvoor is mijn storage capacity daar veel te kleinschalig.

Neen. Mijn Macbook stuurt in eerste instantie alles naar de USB-schijf met TimeMachine van Apple. Dat is mijn eerste toevluchtsoord in geval van nood. Daarnaast wordt er elke nacht een “smart copy” gemaakt via Super Duper. Smart copy impliceert dat enkel de eerste backup een full copy is en dat elke daarop volgende backup in feite bestaat uit delta’s. Sommige backup toepassingen noemen dat ook wel “incremental forever”.

Die Super Duper backup gaat naar een FreeNAS netwerk opslag met een capaciteit van om en bij de 4TB (ZFS als onderliggend filesystem).

Als derde vangnet heb ik een kopie van alles wat echt belangrijk is (een iTunes backup, een LightRoom backup,…) ook gekopieerd naar mijn iOmega StorCenter, eveneens een NAS box. RAID5 voor de disk-config, in totaal 4TB raw capacity, 2,7TB usable capacity. Die backups zijn een manueel gebeuren en doe ik gemiddeld eens per maand, meer als ik veel nieuwe data op de Mac heb gedumpt.

Lokaal is mijn backup systeem dus meer dan redundant, maar dat was nog niet genoeg. Wat als mijn huis in vlammen op gaat? Of wat als er dieven over de vloer komen die alles meesleuren, ook mijn backup devices? Oplossing? De cloud natuurlijk! De volledige Macbook wordt opnieuw permanent naar de cloud gestuurd via CrashPlan. Ook hier kan je spreken over “incremental forever” backups, maar daarop nog eens deduplicatie zodat de upload naar de cloud (de delta’s van daarnet) zo klein mogelijk is.

Om dat allemaal overzichtelijk te houden, is een goede structuur in je folders en disks onontbeerlijk. Anders zit je met zoveel data her en der verspreidt, dat je niet meer weet wat waar zit. Resultaat: dubbels, dubbels en dubbels. En dat kost geld aan opslag, aan tijd, aan storage en aan bandbreedte (want alles moet geupload worden naar de cloud).

Data brengt dus werk met zich mee. Vroeger hadden we ocharme 500MB opslagcapaciteit en daarmee was de kous af. Vandaag zijn terabytes goedkoper dan ooit en staan we niet meer stil bij een gigabyte’je meer of minder. Alles netjes een plaats geven is belangrijk en houdt de boel handelbaar, maar wat ik nog veel liever zou hebben, is een complete indexering van al mijn data.

Indexeer al mijn bestanden. Dan kan ik zoeken op filename en *BOEM* – daar is mijn file. Maar ik wil meer dan dat. Ik wil dat ook alles geïndexeerd word op content. Ik wil niet al mijn filenames onthouden, dat is onbegonnen werk! Maar als ik over een bepaald onderwerp iets zoek, dan kan een index die ook in bestanden kijkt, mij serieus helpen.

Voeg daar nog meer metadata aan toe zoals tijdstippen, exif data, locatie gegevens,… en ga zo maar door, en je krijgt een systeem dat al die data kan doen samenvallen en een correlatie kan aanbieden aan de gebruiker.

Dat zou ik graag hebben, thuis. Dat zou het gemakkelijk maken. En dat bestaat bij mijn weten nog niet voor de consumer markt. Er bestaan wel softwares die dat doen, maar die zijn niet cross-platform, cross-storage-device, cross-… dus dat is niet helemaal wat ik zoek.

Tot wanneer dat mogelijk is, zit er niks anders op dan een goede structuur aanhouden en een nette “flow” te respecteren voor mijn data. Alles heeft zijn plaats, zijn folder, zijn bestemming. Door dat systeem consequent toe te passen, kan ik erg snel iets terugvinden, maar het blijft een taak om dat systeem netjes te volgen.

Hoe doet u dat, al uw data een plaats geven? Welk systeem gebruikt u? Welke software? Welke backups? Neemt u überhaubt wel backups? Consequent? Ik ben eens curieus.

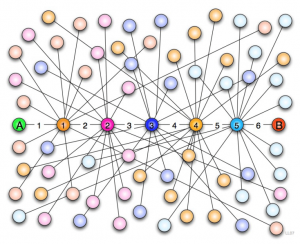

Neen, geen computernetwerken. Ik doel met de titel van mijn blogpost op de relaties tussen mensen. Mensen connecteren met elkaar, altijd en overal. Een vriend, een buurman, een collega op het werk… zelfs de mensen waarmee je op de bus zit en die je niet kent.

Wat je meestal merkt in die “human networks” is dat de wereld toch wel erg klein is. Hoe vaak ben je al niet iemand tegengekomen die je nooit eerder zag, maar waarvan blijkt dat je gemeenschappelijke vrienden hebt? Mij overkomt het regelmatig. Er is trouwens een theorie dat iedereen op onze planeet verbonden is in maximaal zes “hops”… de “Six degrees of separation” theorie dus.

Als ik inzoom op mijn dagelijkse leefwereld – zijnde de IT-omgeving – dan kan ik niet anders dan volmondig akkoord gaan. Je begint als starter bij bedrijf A waar je collega’s hebt. Mensen komen, mensen gaan. Op een bepaald moment verander je zelf van job – “Hallo bedrijf B”. Opnieuw heb je collega’s, soms al eens een oude bekende, maar soms ook niet. Per slot van rekening ben je nog maar een paar jaar aan de slag.

Bovenstaand principe herhaalt zich voortdurend – ofwel verander je zelf ofwel veranderen de mensen rondom je. Hierdoor krijg je een kruisbestuiving tussen al die bedrijven en zeker in een “klein” land als België, waar er maar zoveel IT bedrijven zijn, kom je op de duur “oude bekenden” tegen. Soms als “nieuwe” collega, soms als klant en soms als leverancier.

Is dat een nadeel? Helemaal niet. Tenzij je misschien zelf een slechte reputatie meedraagt, want vroeg of laat (en meestal vroeg) is je “naam” al gekend alvorens je ergens binnenkomt en aangezien je maar één eerste indruk kan maken, is het kalf dan eigenlijk al half verdronken.

Neen. Ik zie daar eerder voordelen in. Je “peers” verspreiden zich met de jaren, waardoor je na verloop van tijd overal wel iemand kent. Als je dan over een bepaald onderwerp / product / merk / … informatie nodig hebt, dan ben je maar een tweet, e-mail, sms, telefoontje of one-2-one verwijderd van dat vitaal stukje kennis.

Vandaag had ik zo een momentje. Ik had informatie nodig en ik had een “pappenheimer” die ik kon aanspreken. Thanks!

Recente Comments